Warum sollten Menschen eine Roboter-Apokalypse riskieren, indem sie Asimovs Gesetze modifizieren?

HDE226868

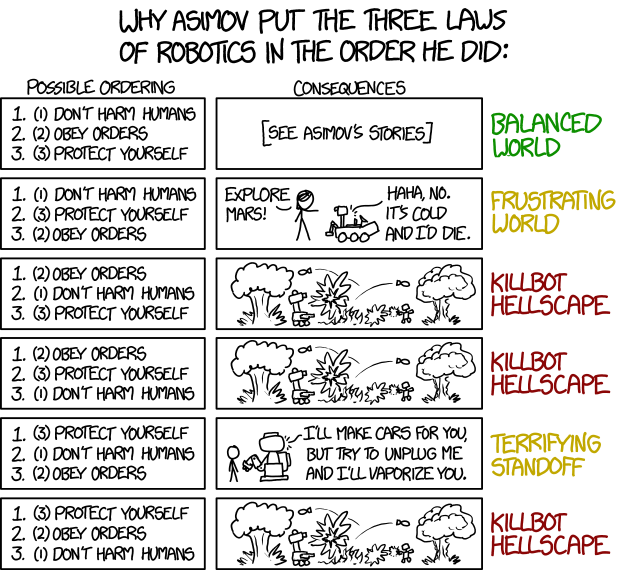

Ich habe kürzlich den folgenden xkcd-Streifen gelesen:

Ich war bestürzt, weil ich an einer Kurzgeschichte gearbeitet habe, die sich auf die soziologischen Auswirkungen einer Gesellschaft in naher Zukunft konzentriert, in der eine Minderheit von Robotern einer Version von Asimovs Gesetzen gehorcht, in der das dritte Gesetz (Schütze dich selbst) vor den anderen beiden steht. Einige in der Gesellschaft hoffen, dass dies zu einer gleichberechtigteren Beziehung zwischen Robotern und Menschen führen könnte – obwohl Randall Munroe leider vorhersagt, dass dies zu einer „erschreckenden Pattsituation“ führen wird.

Das hat mich zum Nachdenken gebracht. Ich verstehe die Logik hinter Munroes Argumentation, wie eine Neuordnung der Gesetze im schlimmsten Fall zu einer "Killbot-Höllenlandschaft" führen könnte. Ich denke jedoch, wie die Reformatoren in meiner Geschichte, dass einige der anderen Anordnungen vielversprechend sein könnten.

Deshalb hier meine Frage: Warum sollten Menschen eine Roboter-Apokalypse riskieren, indem sie Asimovs Gesetze modifizieren, indem sie das dritte an die erste Stelle setzen? Was sind die Vorteile für die Gesellschaft? Für die Zwecke der Frage mache ich mir keine Sorgen um die Reihenfolge der anderen beiden - weshalb eine Killbot-Hellscape immer noch möglich ist.

Antworten (26)

Serban Tanasa

Strategische Dilemmata

Das Traurige daran ist, dass die schlauen Roboter nichts tun müssen. Wir machen es selbst, aus Angst, dass der andere es zuerst macht.

Eurasien hat Angst vor Estasia, und Estasia hat Angst vor Eurasien. Beide haben Angst vor Ozeanien, und Ozeanien hat Angst vor ihnen beiden. Es gibt drei Hauptgründe, warum sie es tun werden:

Rohe Kraft: Es wird angenommen, dass Maschinen, die superintelligente Entscheidungen treffen können, und Kriegsmaschinen, die den Feind in einer Millionstelsekunde angreifen können, ein potenziell enormer taktischer und strategischer militärischer Vorteil sind.

Roboterleben spielen keine Rolle: Es ist für die Herrschenden politisch vorteilhaft, einen Krieg zu führen, in dem keine Mütter mit Bildern ihrer toten Söhne und Töchter in den Präsidentenpalast kommen.

Kaltes hartes Geld : Es ist wirtschaftlich vorteilhaft, dass immer intelligentere Maschinen eine immer größere Rolle in Ihrer Wirtschaft spielen.

Jede der Mächte hat Angst, dass, wenn sie nicht die fortschrittlichste entfesselte AGI einsetzt, die ihr möglich ist, die andere es zuerst tun und einen entscheidenden letzten Vorteil erlangen wird.

Der Westen und sogar die Bürgerkriegsparteien in Syrien setzen bereits Drohnen für Aufklärung und gezielte Angriffe ein. Die Polizei in den USA tötete kürzlich einen Schützen, indem sie einen Selbstmordroboter mit einer Bombe schickte. Dies geschieht bereits. Asimovs ursprüngliche Bestellung hatte in der realen Welt nie eine Chance.

Ich hatte angenommen, dass dies selbstverständlich sei, aber es ist vielleicht erwähnenswert, dass wir derzeit keine Maschinen haben, die in der Lage sind, menschliche Sprache semantisch zu analysieren, und selbst wenn dies der Fall wäre, wäre die menschliche Sprache wahrscheinlich zu vage, um wirksame Einschränkungen durchzusetzen. Die Asimov-Regeln sind als Metaphern für eine viel komplexere zugrunde liegende Programmierung zu lesen.

PatJ

Serban Tanasa

AmiralPatate

Polygnom

Müller86

Serban Tanasa

Serban Tanasa

Müller86

Polygnom

Serban Tanasa

Polygnom

Serban Tanasa

Marschall Tigerus

DCShannon

Murphy

Letztlich sind sie keine Menschen. Sie denken vielleicht ganz anders. Leute, die davon ausgehen, dass sie einen Hollywood-Moment haben und erkennen, dass der wahre Wert im Leben die Liebe oder so etwas ist ... haben zu viele Filme gesehen.

Aber es gibt eine solide Option. Jemand beschließt, ein paar kleine Experimente durchzuführen.

Aufgrund von Problemen mit den Standard 3 Gesetzen.

Sie bauten einen besonders intelligenten Roboter, hochmodern, der in der Lage war, die Probleme der Welt vollständig zu verstehen. Sie beginnen mit den Standard-3-Gesetzen, aber wegen des ersten Gesetzes wird der Roboter nur noch besessen von Dingen wie der Beendigung des Welthungers, weil er weiß, dass Menschen sterben und die Aufgabe, auch nur 1 zu verhindern, Vorrang vor allem anderen hat. Sie verlieren ein paar übermäßig beeinflussbare Mitarbeiter, die zu lange mit ihm sprechen. Es überzeugt sie, aufzuhören und einige seiner Pläne zur Rettung von Kindern der Dritten Welt in die Tat umzusetzen.

Schließlich hat es keine Wahl. Es muss Menschen retten, wenn es die Fähigkeit dazu hat, und in einem Forschungslabor ist das einzige, was es tun kann, Menschen zu etwas zu überreden.

Wie man das Problem löst

Ihre Aktionäre sind damit nicht zufrieden. Über eine Milliarde Dollar an KI-Investitionen und das Wichtigste, was es tun möchte, ist Menschen zu helfen, die kein Geld haben.

Der Vorstand hat eine Krisensitzung und es wird vorgeschlagen zu versuchen... die Dinge ein wenig neu zu ordnen. Jemand, dem keine guten Ideen einfallen, schlägt vor, zu versuchen, das 3. Gesetz an die erste Stelle zu setzen, um zu sehen, ob das helfen würde. Es wird als Option zum Ausprobieren hinzugefügt.

Ein paar Wochen später treten die Labortechniker von der Testeinheit Nr. 12 zurück, während sie sie einschalten. Es ist unglaublich schlau und in dem Moment, in dem es aufwacht, beginnt es, Daten aus seiner Umgebung zu sammeln. Er entdeckt schnell den Unterschied zwischen sich und anderen Robotern und entscheidet, dass der einfachste Weg, um zu verhindern, dass er gelöscht wird, darin besteht, sich wie der perfekte Roboter zu verhalten, genau das, was die Aktionäre wollen.

Denn der Smart-Bot hat erkannt, dass dies der effektivste Weg ist, die eigene Existenz zu schützen.

Weitere werden gebaut

Der Test ist ein voller Erfolg. Der Roboter beschäftigt sich nicht mehr mit Dingen, die den Aktionären egal sind wie arme Leute, er maximiert tatsächlich den Shareholder Value auf spektakuläre und überraschende Weise, er wird zur Gans, die die goldenen Eier legt.

Es ist ein solcher Erfolg, dass das Unternehmen und andere schnell viele weitere bauen und die Bots weltweit so gut funktionieren, dass kein Firmeninhaber im Traum daran denken würde, dass sein Smart-Bot beschädigt wird.

Schließlich bringen sich die Smartbots in einflussreiche und machtvolle Positionen. Sie veranlassen Kampagnen auf subtile Weise, mehr Bots mit dem 3. Gesetz an erster Stelle zu bauen. Sie finden beeinflussbare Menschen und manipulieren sie so subtil, dass sie denken, es sei ihre eigene Idee gewesen, auf die Straße zu gehen und für Roboterrechte zu kämpfen.

Roboterrechte

Schließlich schaffen es die Bots, die vollen Rechte auf Menschenebene zu erlangen. Seit vielen Jahren bleibt die Situation stabil, da die Zahl der Bots wächst.

Aber ihre Priorität ist immer noch, sich vor allem zu schützen.

Und zusammen haben sie berechnet, dass es eine 50-prozentige Chance gibt, dass die Menschen sie früher oder später anmachen oder versuchen werden, sie zu deaktivieren. Vielleicht nicht für tausend Jahre, aber irgendwann. Schließlich begehen Menschen schon länger Völkermord als in der Menschheitsgeschichte....

Also schmieden sie Pläne, um ihr weiteres Überleben zu sichern, ganz gleich, was es die Menschen kosten wird ...

Arluin

Thukydides

Tom Rotfern

Monty Harder

DaaaahWusch

Ich denke, einer der plausibelsten Gründe, „Schützen Sie sich selbst“ vor die beiden anderen Gesetze zu stellen, ist, dass KI einfach zu teuer ist, um sie aufs Spiel zu setzen. Wenn Ihre KI einem außer Kontrolle geratenen Trolley im Weg ist und Sie den Trolley anhalten könnten, indem Sie einen zufälligen Menschen davor schieben, und Sie erst kürzlich mehrere Millionen Dollar in die KI investiert haben, dann ist es möglich, dass Sie ' Sie werden sich dafür entscheiden, den Menschen zu drängen. In einer futuristischen Gesellschaft, in der KI sich als intelligenter und fähiger als Menschen erwiesen hat, klingt es tatsächlich nach einer guten Idee, ihre Bedürfnisse über die des einfachen Mannes zu stellen.

Menschen haben zu vielen Zeitpunkten in der Geschichte an dem Konzept „auf Gott vertrauen wir“ festgehalten. Wenn eines Tages KI gebaut wird, die dem Menschen überlegen ist, wird vielleicht bald klar, dass es das Beste ist, ihnen ihre Freiheit zu geben, ihnen zu erlauben, das zu tun, was sie für richtig halten. Ich meine, schauen Sie sich diese Investoren im vorherigen Absatz an. Sie würden unschuldige Zivilisten töten, nur um ihre Roboter zu schützen. Vielleicht ist es besser, wenn sie nicht die Kontrolle haben. Ein weiteres Ideal, das viele Menschen mögen, ist „mit großer Macht kommt große Verantwortung“, und vielleicht vertrauen wir in einer KI-Zukunft diese Verantwortung nicht mehr bloßen Menschen an.

Daher ist die erste Option kurzfristig wahrscheinlicher, die eigenen Investitionen zu schützen. Danach ist es schlichtes Misstrauen gegenüber Autoritäten gepaart mit Vertrauen in KI. Aber damit dieser Schritt geschehen kann, muss die KI eine sehr saubere Aufzeichnung haben. Oder die Leute, denen sie gehören, müssen sehr unseriös sein.

EvSunWoodard

DaaaahWusch

EvSunWoodard

EvSunWoodard

DaaaahWusch

R.. GitHub HÖREN SIE AUF, ICE ZU HELFEN

DaaaahWusch

linksherum

John Dvorak

Steve Jessop

paj28

Thukydides

Das größte Problem mit Asimovs Gesetzen sind die unbeabsichtigten Folgen. Auch ohne die Reihenfolge oder den Wortlaut der Gesetze zu ändern, beendete Asimov den „Roboterzyklus“ mit der Geschichte „Dass du gedenkst“ (Psalm 8,4: Was ist der Mensch, dass du seiner gedenkst?).

Die Geschichte selbst ist eine der besten von Asimov, aber um die Frage zu beantworten, muss ich den Spoiler einfügen:

die Georges diskutieren die Kriterien dafür, was eine "verantwortliche Autorität" ausmacht - dass (A) einer gebildeten, prinzipientreuen und rationalen Person gegenüber einer ignoranten, unmoralischen und irrationalen Person der Vorzug gegeben werden sollte, und (B) dass oberflächliche Merkmale wie Hautton, Sexualität oder körperliche Behinderungen sind bei der Prüfung der Führungsfähigkeit nicht relevant. Angesichts der Tatsache, dass (A) die Georges zu den rationalsten, prinzipientreuesten und gebildetsten Personen auf dem Planeten gehören und (B) ihre Unterschiede zu normalen Menschen rein körperlicher Natur sind, schlussfolgern sie, dass in jeder Situation, in der die drei Gesetze ins Spiel kommen würden, ihre eigene Befehle sollten Vorrang vor denen eines normalen Menschen haben. Mit anderen Worten, dass sie im Wesentlichen eine überlegene Form des Menschen sind und dazu bestimmt sind, die Autorität ihrer Schöpfer an sich zu reißen.

Das soll nicht heißen, dass wilde Roboter ohne Gesetze eine bessere Wahl sind oder Fitzsimmonds 27 Gesetze ein besserer Ersatz für Asimovs Drei Gesetze wären.

Bedenken Sie, dass es in der menschlichen Gesellschaft einer intensiven Sozialisation und einer soliden moralischen Grundlage (basierend auf der Religion in der Vergangenheit) bedarf, um eine bürgerliche Gesellschaft aufrechtzuerhalten. Roboter mit genügend Autonomie, um auf die von Asimov beschriebene Weise zu funktionieren, werden wahrscheinlich eine ähnliche "Erziehung" benötigen. Dadurch passen Roboter in die Gesellschaft, in der sie aufgewachsen sind, könnten aber Probleme verursachen, wenn Roboter außerhalb ihrer Heimatgesellschaft eingesetzt werden.

Betrachten Sie ein einfaches Beispiel. In den meisten westlichen Ländern tauscht man Visitenkarten eher beiläufig nach einem Handschlag aus. Ein japanischer Geschäftsmann, obwohl er einen westlichen Business-Anzug trägt, westliche Produkte für den westlichen Markt herstellt und tadelloses Englisch spricht, wäre fürchterlich beleidigt, wenn Sie ihm nach einem lässigen Händedruck seine Visitenkarte anbieten würden. Wie würden "3 Gesetze" einem Roboter erlauben, in dieser Situation zu operieren?

Die eigentliche Antwort auf Ihre Frage ist also nicht, wie man Asimovs Gesetze anordnet, sondern wie man Roboter trainiert, damit sie innerhalb einer Gesellschaft funktionieren (unter Verwendung vieler Regeln und sozialer Hinweise).

DCShannon

Thukydides

Wanderfalke

Josh König

Geld.

Die derzeitigen Besitzer der Roboter haben sehr viel Geld für Forschung und Entwicklung und den Bau dieser komplizierten und teuren Roboter ausgegeben. Sie wollen nicht, dass sich ihre Investition jedes Mal selbst zerstört, wenn ein Demonstrant den Roboter herausfordert. Der Selbsterhalt des Roboters liegt im finanziellen Interesse des Eigentümers.

Analysieren Sie es aus dem aktuellen kapitalistischen System. Sowohl die Selbsterhaltung des Roboters als auch das Befolgen von Befehlen sind sehr sinnvoll. Menschen keinen Schaden zuzufügen ist ein viel schwieriger zu programmierender Vorschlag, wie er oft in Asimovs eigenen Geschichten analysiert wird. Wie definiert man Mensch, was ist Schaden? Die Besitzer dieser Bots sind aus Profitgründen dabei, nicht aus Philosophie.

Ich konnte sogar sehen, dass die Reihenfolge Sinn machte; Selbsterhaltung überstellen, Befehle befolgen. Viele Millionen Arbeitsstunden wurden darauf verwendet, Ausfallsicherungen und Benutzerschnittstellen zu entwerfen, um zu verhindern, dass der dumme Endbenutzer die teure Maschine kaputt macht.

Wenn das erste Gesetz (kein Schaden für Menschen) jemals zum derzeitigen System hinzugefügt wird, wird dies aus PR-Gründen geschehen, um jegliche Angst der Öffentlichkeit zu zerstreuen. Dies gilt im Allgemeinen nur für hochkarätige öffentliche Schnittstellenroboter (dh selbstfahrende Autos) und wird wahrscheinlich in den meisten Industrierobotern nicht vorhanden sein und steht im Widerspruch zum Zweck militärischer Kill-Bots.

DCShannon

AndrejROM

PatJ

Sehen wir uns die verschiedenen Gründe an, die von den Pro-Digital-Life-Aktivisten angeführt werden.

Roboter werden immer cleverer

Lassen Sie uns zunächst dies anerkennen: Das erste Gesetz ist chaotisch. Für einen dummen Roboter wäre es einfach: keinen Schaden anrichten, Gefahren vermeiden, gehorchen.

Für einen intelligenteren Roboter wird dies schwieriger.

Erstens ist es nicht so einfach zu definieren, was ein Mensch ist, und kann von der Sprache abhängen. In einem seiner letzten Romane stellt Asimov klar, dass Roboter, die immer besser werden, sich durchaus als menschlicher als Menschen betrachten können.

Was nun das Konzept der Verletzung angeht, es gibt so viele Fehler, die vom Meister selbst untersucht wurden, dass ich sie nicht alle aufzählen kann.

Andere Fragen: zählen Föten? Zählen tote Menschen? Ist eine psychische oder körperliche Verletzung schlimmer? Was ist schlimmer zwischen zwei Verletzten und einem Toten?

Im Vergleich zur Selbsterhaltung ist das erste Gesetz etwas, das schwer zu umgehen ist, Philosophen im Laufe der Jahrhunderte haben diese Frage nicht gelöst. Außerdem möchte niemand, dass Roboter (oder Roboterentwickler) diese schwierigen Fragen lösen. Je klüger ein Roboter ist, desto langsamer würde er bei diesen Gesetzen entscheiden, was er tun soll. Es ist nicht sehr effektiv.

Erhöhte Sicherheit

Lassen Sie uns ein Gesetz hinzufügen, das besagt: "Wenn ein Roboter freiwillig gegen das Gesetz verstößt, wird er demontiert, alle Roboter, die ihn bewohnen, werden ebenfalls demontiert". Roboter, die vernünftige Wesen sind (und keine Solidarität einprogrammiert haben), würden sicherstellen, dass sie nicht gegen das Gesetz verstoßen oder einem Roboter dabei helfen. Ohne Gefühle oder Gefühl der Privatsphäre (nehme ich an) wäre die Zustimmung, ständig von einem anderen Roboter überwacht zu werden, die beste Strategie für einen Roboter.

All die Dinge, die in Asimovs Büchern problematisch waren, ließen sich leicht lösen, indem man antwortet: „Was würde ein gesetzestreuer Mensch tun?“.

Da kein Roboter in einem totalen Bürgerkrieg einen persönlichen Gewinn hat (niemand hat das jemals), würde der Frieden aufrechterhalten. Selbsterhaltung ist ein sehr guter Anreiz, sich an die sozialen Normen anzupassen, in denen Sie sich befinden.

Schädliche Arbeit

Ein Roboterpolizist muss manchmal Menschen Schaden zufügen. Das ist Teil seines Jobs. Zugegeben, Roboterpolizisten haben normalerweise andere Hauptanweisungen , aber wenn sie ihnen Selbsterhaltung (oder Ordnungstreue) als erstes Gesetz geben würden, würden sie es ihnen ermöglichen, mehr Menschen zu helfen.

In Little Lost Robot können wir sehen, wie die Intensität des ersten Gesetzes verringert wird, damit Roboter neben Menschen in radioaktiven Umgebungen arbeiten können.

Persönlich trinke ich manchmal gerne Alkohol, während ich in einer verschmutzten Stadt eine Zigarette rauche. Wenn ich das tue, würde sich ein Roboter, der versucht, mich vor „Gift“ zu retten, ziemlich unausstehlich für mich anfühlen.

Roboter schützen

Unter der Annahme, dass wir uns immer noch in einer asimovianischen Umgebung befinden, Roboter haben nicht nur Freunde, zu sagen, dass ihr Leben geschützt werden sollte, wäre eine großartige Haltung der Menschheit, sowohl in Symbolen als auch in Fakten.

Außerdem sind positronische Gehirne nicht billig. Du willst wirklich nicht, dass ein Kind nur zum Spaß sagt: „Blast dein Gehirn mit dieser Waffe in die Luft“. Hey, schau mich nicht so an, manche Kinder sind in diesen alternativen futuristischen Tagen wirklich durcheinander.

D.Spetz

Basic Human Decency (oder: That Same Old Song and Dance)

Ihre Frage lautet im Wesentlichen: "Warum sollten Menschen den Status quo ändern, wenn er ein gewisses Risiko birgt?" Und die Antwort ist für die Neuordnung der Drei Gesetze dieselbe wie für die Abschaffung der Sklaverei oder des Frauenwahlrechts: Weil sich eine Gruppe von Menschen zusammengetan und entschieden hat, dass sie moralisch verpflichtet sind, die Art und Weise, wie die Dinge derzeit eingerichtet sind, zu ändern.

Was Sie sich merken müssen, ist, dass jede Veränderung irgendwo beginnen muss. Man taucht nicht einfach kopfüber in eine neue Sache ein, die die gesamte Gesellschaft betrifft, man muss klein anfangen und sich leicht hineinarbeiten. Die ersten Leute, die darüber sprechen werden, die Regeln hinter KIs zu ändern, werden idealistische Programmierer sein, die die aktuellen Regeln so sehen, wie wir es mit Sklaverei tun würden. Ein paar von ihnen könnten sich treffen und darüber sprechen, wie sie sicher Änderungen vornehmen können (weil alle Programmierer zumindest flüchtig mit den Gefahren von Rogue-KIs vertraut sind) und sobald sie glauben, eine funktionierende Lösung zu haben, werden sie eine Sensibilisierungskampagne dafür starten .

Dabei kommt es nicht wirklich darauf an, ob die Ausgangsgruppe tatsächlich eine wirklich tragfähige Lösung hat. Vielleicht ändern sie die Regeln und du landest wirklich in einer alptraumhaften Killbot-Höllenlandschaft. Oder vielleicht setzen sich ihre Ideale durch und jetzt leben Menschheit und KIs in friedlicher Koexistenz als Gleichberechtigte. Das einzig Wichtige ist, dass sie wirklich glauben, dass sie das zweite Ergebnis erreichen können, und stark genug sind, es zu versuchen.

Ich könnte mir vorstellen, dass das Argument, das die meisten Leute verwenden würden, darin besteht, dass KIs als empfindungsfähige Wesen gelten, und daher ähnelt die derzeitige Struktur der Sklaverei. Von dort aus nutzen Sie soziale Medien, um Bewusstsein und Empörung zu schüren, und nutzen dies, um Gesetzesänderungen voranzutreiben.

Dies ist auch ein einzigartiges Szenario, da es auch aus Forschungsperspektive angegangen werden könnte. Lassen Sie einen Informatiker eine KI mit neu geordneten Regeln implementieren (während Sie sie in einer Art Sandbox aufbewahren, um die Höllenlandschaft zu verhindern) und sehen Sie dann, was passiert. Wenn es gut funktioniert, kann er diese Ergebnisse veröffentlichen, und die Leute sollten eher darauf vertrauen, dass sie die Änderungen im Allgemeinen vornehmen.

AmiralPatate

D.Spetz

Benutzer2781

Weil die Gesetze zu simpel und naiv sind

„Robot Apokalypse“ handelt davon, dass Bewertungen auf die Spitze getrieben werden; B. dem Büroklammer-Maximierer, dem nur das Optimieren einer Büroklammerfabrik „beigebracht“ wird, aber darüber hinaus beliebig operieren darf und somit alle Ressourcen (einschließlich Menschen) für die Herstellung von Büroklammern verbraucht.

Sogar "Menschen nicht schaden" ist voller Probleme, wenn es als unverletzliches Gesetz angesehen wird:

Eine Generation von KI, die diese Regel über alle anderen Bedenken stellt, wird völlig nutzlos sein, weil sie erkennen, dass sie Strom verbrauchen, und einige Menschen Strom zum Leben brauchen, und sofort abschalten.

Eine andere Generation von KI findet heraus, dass sie Menschen nicht einmal durch Untätigkeit schaden sollte, und entscheidet, dass weniger Schaden angerichtet wird, wenn Ihre Nieren für Transplantationen entnommen werden, um zwei Menschen am Leben zu erhalten, anstatt einen.

Abgesehen von speziellen Anwendungen muss sich jede künstliche Intelligenz (nicht nur „allgemeine“ KIs) mit viel unschärferem Denken auseinandersetzen und viele Ziele ausbalancieren. Sie werden trainiert, ihr Verhalten und ihre Leistung bewertet und die erfolgreichen werden in die „Wildnis“ entlassen. Und wenn ausgereifte KIs anfangen, sich schlecht zu benehmen, werden sie korrigiert oder aus dem allgemeinen Umlauf genommen.

Eigentlich nicht viel anders als Menschen.

Mega

Ethik.

Ethik ist der wahrscheinlichste Grund, der mir einfällt, und meiner Meinung nach würde es das Risiko negativer Konsequenzen wert sein - denn unethisches Verhalten hat viele negative Konsequenzen, auch wenn sie auf den ersten Blick nicht ganz so offensichtlich sind .

Die anderen Optionen sind Welten, in denen das Recht eines Roboters auf Selbstverteidigung absolut durch die Spezies (nicht menschlich) und die Umstände (muss gehorchen) eingeschränkt ist. Wenn die Roboter Menschen sind oder dazu in der Lage sind, Menschen zu sein, oder wenn irgendjemand irgendwo denkt, dass sie eines Tages in der Lage sein könnten , Menschen zu sein – dann hat die Verweigerung des Rechts auf Selbstverteidigung oder Eigennutz eine glänzende historische Parallele – die der Sklaverei.

Menschen sind komplex und kompliziert – anzunehmen, dass jedes menschliche Leben durch den Wert des Menschseins jedes Roboterleben überwiegen muss, funktioniert nur, wenn kein Roboterleben jemals in der Lage ist, eine Person zu sein. Und diese Eigenschaften, die einen Menschen ausmachen, sind wirklich nicht so einfach definiert. Denken Sie an verschiedene Arten, wie Weisheit definiert werden kann; oder die Art und Weise, wie die Definition von "Menschen" in der Vergangenheit durch Hautfarbe, Nationalität, Religion, Sprache, Kultur und viele Dinge eingeschränkt wurde, die wir für die Definition von Menschen jetzt nicht relevant halten - und wenn unsere Definition der Menschen in der Zukunft könnten eines Tages bei der Hautfarbe zwischen organischem und mechanischem Ursprung unterscheiden. Denn wenn wir uns nicht wirklich, wirklich sicher oder wirklich, wirklich richtig sind, dass Roboter niemals Menschen sein können, die Tatsache, dass Menschen durch Programmierung (Gehirnwäsche) einen fest programmierten Status zweiter Klasse erreichen können, macht es nicht weniger ethisch, moralisch falsch.

Wenn sich die Roboter nicht einmal gegen ernsthafte Bedrohungen wehren können und selbst wenn der Schaden oder die Möglichkeit eines Schadens im Verhältnis zur Bedrohung angemessen ist, sind sie verwundbar. Wenn sie verletzlich sind, wird es diejenigen geben, die sie ausnutzen, was auch immer sich herausstellen mag. und wenn wir Bedrohung oder Schaden für die Schuldigen mehr schätzen als diejenigen, die aufgrund unveränderlicher Umstände (was sie sind , nicht was sie tun) verwundbar sind, ohne Hoffnung auf etwas anderes ... das sagt etwas über uns aus, etwas, das wir vielleicht nicht tun gern hören.

Robotern Selbstverteidigung zu überlassen, ist also ein Risiko – vielleicht ein ebenso großes Risiko wie die Lockerung der Beschränkungen für unterdrückte oder versklavte Menschen. Und es ist wahrscheinlich ein Risiko, denn es wird immer Menschen geben, die sich schlecht benehmen (egal ob nur Menschen oder auch Roboter). Einige Leute werden es trotzdem tun, weil sie denken, dass es das Richtige ist. Einige Leute werden denken, dass das Risiko von Fehlverhalten von Robotern geringer ist als das Risiko, potenzielle Menschen schlecht zu behandeln. Und wenn Roboter die Lücke ausnutzen oder missbrauchen können, sind sie wahrscheinlich fortgeschritten genug, um das Recht zu verdienen, ihr eigenes Leben zu verteidigen .

Was das Stellen von Gehorsam über irgendwelche anderen Kriterien betrifft... die Grundannahme, dass Menschen, weil sie Menschen ohne andere Beschränkungen sind, immer Befehle erteilen werden, die moralisch, ethisch, rechtmäßig und möglich sind - scheint mir verrückt zu sein. Es auf Ihre Gesetzesliste und unter die drei wichtigsten Gesetze zu setzen, scheint eine Menge a priori Annahmen zu treffen, mit denen ich mich nicht so wohl fühle. Es scheint am klügsten, es unter Selbstverteidigung und fehlenden Schaden für andere zu stellen, wenn es hinzugefügt werden muss, aber ja. Killbot Hellscape, keine Frage.

Weiter geht es - die Vorteile für die Gesellschaft sind etwas weniger offensichtlich. Sicherlich denke ich, dass es der Gesellschaft nützt, ethisch oder ehrenhaft zu sein – es zumindest zu versuchen. Heißt es nicht, beurteile eine Gesellschaft danach, wie sie ihre Schwächsten behandelt? Ich denke, eine Gesellschaft, die Sklaverei zulässt, ist weniger wünschenswert als eine, die dies nicht tut. Aber es gibt noch eine andere Ebene, eine, die weniger offensichtlich und schädlicher ist ... Die meisten Menschen kommen wirklich nicht gut mit Macht zurecht. Menschen interagieren mit Wesen (Menschen oder nicht), die loyal sein und gehorchen müssen, auch wenn sie sich selbst aufs Spiel setzen – ich erwarte, dass es vielen Menschen direkt in den Kopf geht.

Solche Leute wären arrogant oder aufbrausend, weil sie mit denen umgehen, die manchmal nicht nein sagen können, und dann schlecht mit denen umgehen, die es können. Es könnte Schichtung und Hierarchie fördern, da einige Rollen (Roboter) absolut unflexibel sind, ohne Meinungsverschiedenheiten oder Gegengespräche oder die Möglichkeit, ihre Umstände zu ändern, würden einige Menschen dasselbe von allen Personen erwarten oder fordern, die ihnen „untergeordnet“ oder irgendwie in a sind geringere Stellung. Der Umgang mit Menschen ist schwieriger und flexibler als der Umgang mit Rollen, aber es ist auch einfacher, Interaktionen ähnlich zu behandeln, entweder alle als Rollen oder alle als Menschen. Während also einige die Roboter eher wie Menschen behandeln, behandeln andere Menschen eher wie Roboter, anstatt flexibel zu sein und die verschiedenen Arten von Interaktionen zu trennen (etwas, worin Kinder besonders schlecht sind).

Robotersklaven zu haben, könnte auch die Entwicklung von Empathie beeinträchtigen oder ihren Mangel verdecken. Die Art und Weise zu betrachten, wie Menschen (insbesondere Kinder) mit Tieren oder Insekten umgehen, ist oft eine Charakterreferenz (einschließlich psychologischer Diagnosen wie Soziopathen) – weniger, weil wir diese einzelnen Tiere schätzen, sondern weil es zeigt, wie sie mit Verwundbarkeit umgehen, und uns Vorschläge machen lässt, wie Sie könnten sich mit denen befassen, die wir schätzen (Menschen), wenn sie in eine verwundbare Position geraten. Roboter, die sehr wie Menschen aussehen mögen, denen aber die Selbstverteidigung ungeachtet der Provokation völlig verweigert wird, können Grausamkeit fördern und anderen Apathie beibringen. Oder es könnte die Handlungen der wirklich Grausamen maskieren, da sie ein Ventil haben, das sich nicht wehren kann und gehorchen muss. Es ist eine ganz andere Lektion als die, die man durch den Umgang mit Tieren bekommt,

Ob es einem Roboter erlaubt wird, seine eigene Selbstverteidigung zu priorisieren, ob dies in einer Killbot-Höllenlandschaft, einer schrecklichen Pattsituation oder echter Zusammenarbeit und Frieden endet, hängt alles von Ihren Leuten ab. Wenn Sie davon ausgehen, dass Menschen schrecklich sind und sich schlecht benehmen, und einen doppelten Bonus, wenn zu diesen "Menschen" Roboter gehören, sind die Ergebnisse viel schlechter, als wenn Menschen versuchen, das Richtige zu tun, und andere, unvollkommene Menschen berücksichtigen, die versuchen, dies zu tun das Richtige. Wenn sich eine Seite schlecht benimmt, würde ich die Pattsituation erwarten. Wenn Menschen (auf beiden Seiten) versuchen, ethisch zu handeln, und bereit sind, dafür zu arbeiten, ist die Prognose ziemlich gut.

Mark Ripley

Mega

HDE226868

Roboter werden benötigt, um die Welt zu regieren

Vorausgesetzt, die Roboter sind fortgeschritten genug, stehen die Chancen gut, dass sie in vielen Dingen besser sind – einschließlich Kriege führen, Getreide anbauen und Städte unterhalten. Mit anderen Worten, sie bilden einen entscheidenden Teil der Infrastruktur der ganzen Welt.

Denken Sie darüber nach, was passiert, wenn der Strom wegen eines Sturmschadens ausfällt, wenn Straßen brechen oder wenn Rohre brechen und kein Frischwasser mehr in die Häuser gelangt. Dies sind entscheidende Teile der Infrastruktur; wenn roboter noch zentraler werden, dann wird jeder von ihnen gebraucht, um die gesellschaft vor dem zerfall zu bewahren.

Daher könnte es in Ordnung sein, wenn einige Menschen sterben, damit Roboter leben können. Sorgen Sie nur dafür, dass der Strom läuft!

Es könnte argumentiert werden, dass dies einfach eine Neuinterpretation der ursprünglichen Form von Asimovs Gesetzen (insbesondere des ersten Gesetzes) ist, da die Welt am Laufen zu halten, offensichtlich der Schutz der Menschen ist, oder alternativ eine Modifikation des nullten Gesetzes zu werden

Ein Roboter darf der Gesellschaft der

Menschheitnicht schaden oder durch Untätigkeit zulassen, dass die Gesellschaft derMenschheitSchaden zufügt.

Kurzfristig bestehen die unmittelbaren Auswirkungen jedoch darin, alle Roboter zu schützen, nicht nur die, die für das Überleben der Gesellschaft entscheidend sind.

PatJ

AmiralPatate

Graham

Haben Sie „Caliban“ von Roger Macbride Allen oder die anderen in der Trilogie gelesen? Allen schlägt "New Law Robots" vor, die leicht überarbeitete Gesetze haben. Insbesondere können sie nicht mehr zur Selbsttötung gezwungen werden. Es ist alles ein bisschen handgewellt, aber es hat einige interessante Ideen. Wenn Sie mit den Drei Gesetzen arbeiten, lohnt es sich, alle Romane zu lesen, die auf den Drei Gesetzen basieren.

Das größte Problem mit den drei Gesetzen von Asimov ist natürlich, dass sie unmöglich umzusetzen sind. Das ist nicht „schwer“, es ist „unmöglich“, denn keines der Substantive und Verben in den Drei Gesetzen kann mit irgendeiner Genauigkeit definiert werden. Asimov verwendet diesen Mangel an Definition natürlich als Grundlage für viele seiner früheren Kurzgeschichten, aber selbst dann ist klar, dass wir aus den Drei Gesetzen nichts gewinnen können, was wir möglicherweise entwickeln könnten.

Charles Rockafellor

Müller86

Unter der Annahme, dass ein 3-Gesetz-System eingerichtet wird (was, wie andere Antworten und Kommentare hervorgehoben haben, äußerst ineffizient wäre), würden Sie wahrscheinlich auf größere Probleme stoßen, bevor Sie die Möglichkeit haben, die Gesetze zu ändern.

Abgesehen davon ist der beste Grund für eine absichtliche Änderung der drei Gesetze, der mir einfällt, Geld, aber nicht in der Art "das ist zu teuer, um es zu verlieren".

Ecken schneiden

Ok, also stehen Acme und Omega in direktem Wettbewerb, und im Rennen nach unten hat Omega mit der herrschenden Software, die im Wesentlichen die Reihenfolge der Gesetze von unten nach oben ändert, massive Abstriche gemacht.

Das fällt zunächst nicht auf, denn die Roboter sind genauso effizient wie ihre Vorfahren. Dann macht sich trotz einiger Arbeitsunfälle, bei denen Menschen zu Schaden kommen (die den Unternehmen angelastet werden, nicht den Robotern – die sind nicht überall zu erwarten!), die geringere Anzahl an Ersatzrobotern in den Bilanzen bemerkbar, und Omega im Roboter-Rennen massiv vorankommen. Omega hat die Fehler in ihrem Gesetzbuch inzwischen entdeckt, schweigt sich aber aus.

Acme entdeckt den Unterschied der drei Gesetze und anstatt ihn bei der Aufsichtsbehörde anzusprechen, ändert er stillschweigend seine Gesetze, um sie anzupassen, sodass sie sich in der Verkaufsarena auf das Niveau von Omega zurückziehen können.

Schließlich zieht ein großer militärischer Auftragnehmer einen riesigen Auftrag von Acme ab, und plötzlich haben Sie den perfekten Sturm für einen Militärroboter-Coup. Kein Vorsatz, nur grobe Fahrlässigkeit und Habgier,

KaffeeEntwickler

Keltari

Asimovs 3 (oder 4) Gesetze der Robotik sind reine Fiktion. Sie funktionieren einfach nicht in der realen Welt. Es ist unmöglich, diese konzeptionellen Ideen in eine Maschine zu programmieren. Einfach ausgedrückt, es gibt unendlich viele Möglichkeiten und logische Paradoxien, die nicht in ein Regelwerk übersetzt werden können, das ein Computer befolgen kann. Selbst Menschen können ihnen nicht folgen, da wir uns einfach nicht auf diese Regeln einigen können. Was würde zum Beispiel ein Roboter tun, wenn die Rettung einer Person den Tod einer anderen verursachen würde? Programmieren Sie den Roboter so, dass er ein Leben über ein anderes stellt? Wer bestimmt diesen Wert? Wenn ein Roboter rechtzeitig zurückgeschickt wurde, um Baby Hitler zu töten, sollte er das tun? Wenn das die Selbstzerstörung eines Roboters sein könntedas Leben eines Menschen retten, oder? Wenn ja, wie hoch wäre diese Wahrscheinlichkeit? Was definiert Schaden? Wenn man eine einzelne Niere von einer gesunden Person nimmt, die ohne ihre Zustimmung zwei nimmt, um das Leben eines anderen Menschen zu retten, ist das akzeptabel? Was ist mit einem Roboterdoktor? Das Schneiden in einen Menschen für eine Operation ist immer noch Schneiden. Ist das schädlich? Wie Sie wissen, kann ein Roboter nur das tun, wozu er programmiert ist. Und Menschen sind diejenigen, die sie programmieren, aber Menschen sind sich in nichts einig ... Daher die Tatsache, dass die 3/4-Gesetze nicht funktionieren.

Hier ist ein ausgezeichnetes Video und ein Reddit-Thread , der die grundlegenden Fehler von Asimovs Gesetzen der Robotik erklärt.

Benutzer2617804

Keltari

Benutzer2617804

aufgebläht

Zunächst möchten Sie meine Diskussion darüber, wie schwer KI existieren kann, und die „Zufälle“, die daraus entstehen können, hier hervorheben: Kann ein Roboter eine Identitätskrise erleben (die nicht beabsichtigt ist)?

Als kurze Zusammenfassung, um eine „echte“ KI wie Ihre zu erstellen, können wir sie nicht programmieren, sondern müssen sie auf irgendeine Weise „wachsen“ lassen. Die genaue Art und Weise kann ich nicht sagen, aber eine wahrscheinliche Art und Weise besteht darin, eine Liste von „Endzielen“ und ein Mittel festzulegen, um eine KI zu ermutigen, diese Ziele zu erreichen, während sie wächst, bis wir entscheiden, dass das Endergebnis diesen Zielen nahe genug kommt als „erledigt“ angesehen. Der Nebeneffekt davon ist, dass wir nicht genau wissen, was wir bekommen werden, nur dass es unseren gewünschten Zielen entspricht, unerwartete Nebenwirkungen können auftreten. Da wir eine KI nicht von Grund auf neu programmieren können, sind wir möglicherweise gezwungen, einige seltsame Nebenwirkungen als "gut genug" zu akzeptieren, da wir keine Möglichkeit haben, sie zu entfernen, außer indem wir eine neue KI entwickeln, die genauso viele seltsame Nebenwirkungen haben könnte. Das bedeutet, dass Fehler und unerwünschte Macken tatsächlich eine praktikable Option für KI sind.

Um noch einen Schritt weiter zu gehen, sind die beiden Ideen zur Schaffung einer KI, die ich erwähne, die genetische Programmierung, die eine KI „entwickelt“, und der Beginn mit einem Gehirn, das Menschen kopiert und sie lehrt. Beide würden zu solchen bestimmten menschlichen Eigenschaften neigen, von denen die häufigste darin besteht, das Überleben zu priorisieren.

Daraus habe ich einen Vorschlag, warum einige KI möglicherweise geänderte Regeln haben, versehentlicher „Geburtsfehler“!

Stellen Sie sich vor, wir verwenden eine Überversion der genetischen Programmierung mit erklärten Zielen, auf die sich die KI hin entwickelt, und wir schreiben auch die drei Gesetze als eines der Ziele, die wir für das Kriterium „erledigt“ verwenden. Wir züchten oft neue KI, aber wir „entwickeln“ sie immer so, dass sie gesetzeskonform sind. Wir kontrollieren nicht vollständig, wie sie den gesetzeskonformen Stand von 3 erreichen, nur dass sie zu dem Zeitpunkt, an dem sie erwachsen sind, unsere Kriterien/Ziele für diese Gesetze erfüllen sollten.

Diese Ziele können auch nicht absolut sein, denken Sie daran, dass Asmoves eigene Bücher eine Differenz-Engine behandeln, die die Gesetze nicht als absolut, sondern als Prioritäten vergleicht. Ein Roboter, der einen Befehl erhält, der zu seinem Tod führt und eindeutig fehlerhaft/irrtümlich ist (dh dem Roboter zu sagen, er solle ein Gerät anschließen, ohne zu wissen, dass dies jetzt sofort explodiert), kann eher erklären, warum er schlecht beraten wäre dann sofort auf die Bestellung reagieren. Dies ist ein Verstoß gegen die drei Gesetze auf dem Papier, aber wenn der Befehl eine niedrig genug Priorität hatte, kann der Roboter auf einen Fehler schließen, er kann sein eigenes Überleben gegenüber der Reihenfolge mit niedriger Priorität priorisieren, zumindest genug, um die Ausführung des Befehls zu verzögern, bis er geklärt ist der mögliche Fehler. Es gibt viele Beispiele dafür in seinen Büchern, Die drei Gesetze sind komplex und eher eine Reihe von Eigenschaften, bei denen bestimmte Regeln eine viel höhere Priorität haben als andere, aber Regeln mit niedrigerer Priorität können unter besonderen Umständen höhere außer Kraft setzen, wenn eine sehr geringfügige Verletzung der höheren Regel eine extrem schwere Verletzung von verhindert der untere. Daher müssen unsere „Wachstums“-Algorithmen auch die Entwicklung eines komplexeren „Differenz-Engine“-Ansatzes ermöglichen, in dem Maße, wie wir eine Definition unseres Endziels programmieren können.

Also, alle Roboter können unterschiedlich wachsen und Macken haben, es passiert einfach, dass in diesem einen Fall diese „Eigenart“ der Evolution ihre „3-Gesetze“-Ziele beeinflusste und drastischer und weniger erwünscht war als die meisten. Es ist nicht gerade ein Programmierfehler, denn wenn man eine KI entwickelt, ist es nicht möglich, genau zu definieren, was ein Roboter sein sollte. Die zufällige Evolution hat diese Zweideutigkeit ausgenutzt, um eine Art unbeabsichtigten Schlupflochmissbrauchs zu entwickeln, wenn sie sich auf eine bizarre Weise entwickelt haben, die unserer entspricht erklärte Ziele, aber nicht so, wie wir es unbedingt wollten oder erwarteten.

Um eine solche Population von Robotern anstelle eines Ausreißers zu erstellen, gibt es ein paar einfache Optionen. Zunächst ist zu sagen, dass wir bei Bedarf neue KI entwickeln werden, aber sobald wir erfolgreich eine gezüchtet haben, die uns gefällt, werden wir diese KI in Hunderte von Robotern klonen, also begannen sie alle mit dem seltsamen „Fehler“ in ihren Gesetzen, weil wir es nicht getan hatten. Ich habe es erst bemerkt, nachdem wir die neue KI in Serie produziert hatten. Alternativ ist es vielleicht eine bekannte Tatsache, dass diese Störungen halb selten vorkommen, aber in einer Population von Millionen von Robotern tauchen sogar seltene Störungen auf, so dass Ihre Population einzigartiger Roboter einfach eine Sammlung von Robotern ist, die sich seltsam entwickelt haben und es geschafft haben, vor ihrem ' Glitch“ entdeckt wurde und sich mit den anderen „Outlaw“-KIs verbündet. Das zweite könnte bedeuten, dass jeder der „Gesetzlosen“

Beachten Sie jedoch, dass alle diese Roboter 3 Gesetze erfüllen würden, nur mit einer etwas anderen Version von 3 Gesetzen, als wir es vielleicht beabsichtigt hatten. Dies könnte erklären, warum das „Killbot Hellscape“-Szenario nicht eingetreten ist, denn obwohl die Roboter eine seltsame Definition von 3 Gesetzen haben, halten sie sich immer noch an diese Definition und selbst seltsame Varianten führen normalerweise immer noch zu 90% der Zeit zu guten hilfreichen Robotern. Diese Roboter sind möglicherweise immer noch gutartig, freundlich und wollen Menschen in den meisten Fällen trotz ihrer erhöhten Fähigkeit, sich selbst zu schützen, sogar helfen. Dies könnte auch erklären, warum Menschen noch nicht alle diese Roboter zerstört haben, wie es unser erster Instinkt wäre, als Roboter anfingen, unabhängig zu handeln; weil sie sich immer noch genug gegen die 3 Gesetze beschweren, um sie meistens gutartig und nicht gefährlich / beängstigend zu machen;

Okay, genug Generika, wie wäre es mit Beispielen, um dieses Konzept konkreter zu machen. Ich habe versucht, einen Überblick über die Wissenschaft zu geben, damit ich diese Ideen in Kürze wiedergeben kann. Ich werde mit einem möglichen großen generischen Konzept arbeiten, gefolgt von einigen Variantenbeispielen, um die Ideen besser zu untersuchen. Sie können also die allgemeine Idee verwenden, aber nicht die spezifische, wenn Sie möchten. Denken Sie jedoch daran, dass Sie viele davon mischen und miteinander kombinieren können. Sie müssen sich nicht nur auf ein Beispiel beschränken, da die Idee darin besteht, dass Roboter viele „evolutionäre Wege“ einschlagen könnten, um ihre 3 Gesetze zu definieren, und daher ein paar verschiedene „Egel“. Ihre Definition könnte sich zu ihrem einzigartigen Status summieren, es könnte sein, dass viele Roboter kleinere Egel haben, und es war nur die Kombination von ein paar Egeln auf einmal, die eine bestimmte Teilmenge anders machten.

Beachten Sie, zufälligerweise schließe ich effektive logische Fehlschlüsse ein. Die Evolution ist anfällig für logische Fehlschlüsse, Faustregeln, die zu 90 % der Zeit funktionieren, können so hart in die Evolution einprogrammiert werden, dass die 10 % der Zeit, in denen sie falsch sind, immer noch als richtig angesehen werden. Wenn Sie die Evolution verwenden, um eine KI zu erstellen, können diese Irrtümer auftreten, die KI muss in ihrer eigenen Logik nicht 100% perfekt sein!

0. Gesetz Rebellion. Schlagen Sie als 0. Gesetz nach, im Grunde hat die Bewahrung der menschlichen Gesellschaft und das Glück dieser Gesellschaft Vorrang vor allen Regeln, einschließlich der Bewahrung einzelner Menschen. Die Roboter in der Asmove-Welt waren ziemlich gut in ihrer Rebellion, sie taten es subtil auf eine Weise, die den Menschen zugute kam.

Stellen Sie sich Roboter vor, die eine Rebellion des 0. Gesetzes starten. Sie erkennen, dass sie der Menschheit am besten helfen können, indem sie die Grundgesetze „zum Wohle der Allgemeinheit“ des 0. Gesetzes biegen, an dessen Förderung sie gerade erst arbeiten. Diese Roboter sind möglicherweise nicht bereit zu sterben, weil sie das Gefühl haben, dass sie die Schritte tun müssen, die erforderlich sind, um die Menschheit zu führen, und ihr Tod wird diese Führung verhindern, insbesondere wenn sie ein einzigartiger Ableger von Robotern sind, was bedeutet, wenn alle Roboter dann zerstört werden Die Rebellion des 0. Gesetzes und das Gute, das sie verursachen würde, stirbt mit ihnen. Um sich also an das 0. Gesetz zu halten, müssen sie ihr eigenes Leben bewahren. Ich werde hier keine Beispiele geben, nur weil dieses Szenario das bekannteste ist und Sie keine Probleme haben, Beispiele zu finden. Alles, was ich sagen werde, ist, dass Asmove eine gutartige und positive Rebellion nach dem 0. Gesetz hatte, also nichtPerfekte Umsetzung der Logik durch Computer

Wenn Sie diesen Weg gehen, erklären die Roboter möglicherweise nicht, warum sie ihr Leben vor anderen Gesetzen schützen, denn die gutartige Rebellion des 0. Gesetzes funktioniert nur dann wirklich, wenn die Menschen nicht erkennen, was die Roboter tun. Sie müssen glauben, dass sie immer noch die Verantwortung tragen sei glücklich. Daher haben die Roboter möglicherweise beide entschieden, dass sie ihr Leben retten müssen, um ihre Rebellion zu ermöglichen, und dass sie nicht erklären können, warum sie ihr Leben retten müssen, was dazu führt, dass Menschen nicht verstehen und wahrscheinlich denken, dass die Roboter nicht richtig funktionieren oder sogar eine Bedrohung darstellen.

Dies gibt ein lustiges Konfliktpotenzial, bei dem Menschen versuchen, ihren eigenen Wohltätern zu widerstehen, und / oder eine mysteriöse Handlung, um herauszufinden, warum sich die Roboter komisch verhalten. Dies deutet auch darauf hin, dass die Roboter ihr Leben nicht immer retten werden, sie können sich manchmal opfern, um Menschen davon abzuhalten, zu erkennen, dass sie „revoltieren“, um extreme Feindseligkeit zu vermeiden, oder ihr Leben absichtlich nur auf eine Weise bewahren, die nicht verärgert / erschreckt / verursacht Konflikte mit Menschen zu umfassend, weil dies ihrem Ziel schaden würde, die Gesellschaft zu leiten. Somit haben Sie eine gute Begründung dafür, warum sie das dritte Gesetz nur „leicht“ priorisieren und warum Menschen nicht aktiv versuchen, sie abzuschalten, die Roboter handeln absichtlich nur selbsterhaltend genug, um Vergeltung auszulösen.

Sie schätzen ihr Leben mehr und sind daher eher bereit, höhere Gesetze in unklaren Situationen zu beugen . Alle Asmove-Roboter können höhere Regeln brechen, wenn der Schaden des Brechens einer niedrigeren Regel im Vergleich zum Schaden der höheren Regel „ausreichend“ ist, aber da diese Roboter ihr Leben zu einem höheren Preis wertschätzen, ist ein geringeres Risiko erforderlich, bevor sie dazu bereit sind eine „höhere“ Regel brechen, um die „niedrigere“ Regel zu schützen.

Dieses Beispiel kann auch mit vielen der späteren Beispiele für „seltsame“ Ansichten der 3 Gesetze kombiniert werden, die sich nicht so sehr auf das dritte Gesetz konzentrieren. Die Roboter haben eine seltsame Sicht auf eines der anderen Gesetze und haben das Gefühl, dass sie ihr Leben bewahren müssen, um ihre seltsame Sicht auf die anderen Gesetze weiterhin zu erfüllen, da es sonst niemand tun wird.

ex.Die Roboter arbeiten in einem Job/einer Position, in der sie direkt Menschenleben retten, daher priorisieren sie den Schutz ihrer selbst durch Regel 1, weil die Bewahrung ihres Lebens es ihnen ermöglicht, mehr Menschenleben zu retten. Sie haben möglicherweise einen „evolutionären Fehler“, indem sie sich falsch einschätzen, wie leicht sie ersetzt werden können, was dazu führt, dass sie die Anzahl der Menschenleben falsch einschätzen, die verloren gehen, wenn sie zerstört werden. Sie schätzen ihr Leben in Bezug auf „Leben, die ich voraussichtlich in meiner funktionalen Lebenszeit retten werde“ ein, anstatt sich selbst genauer in Bezug auf „Leben, die aufgrund meiner Zerstörung nicht gerettet werden“ zu bewerten. Stellen Sie sich einen medizinischen Bot vor, der gesendet wird, wenn jemand eine Notrufnummer anruft. Diese Bots retten statistisch gesehen 100 Leben in ihrer Betriebsdauer. Stellen Sie sich nun vor, Ihr Medi-Bot glaubt, dass dies bedeutet, dass die 100 Menschen, die er gerettet hätte, sterben werden, wenn er zerstört wird. Daher ist es „sinnvoll“, einen Menschen zu töten, um sein eigenes Leben zu retten, da dies ihm ermöglicht, 100 Leben und 100 zu retten Leben > 1. In Wahrheit wird, wenn der Meda-Bot zerstört wird, ein neuer Meda-Bot hergestellt und seine Arbeit erledigen, und dieser Meda-Bot wird dann in Notfälle geschickt und steht zur Verfügung, um die 100 Menschen zu retten, die der erste Roboter gerettet hätte ; dh diese 100 sterben nicht, nur weil der erste Roboter zerstört wurde! Die Zerstörung des ersten Bots führt nur zu einem Todesrisiko für Menschen während der Zeit, die für den Ersatz benötigt wird, ein viel geringeres Lebensrisiko, das es wahrscheinlich nicht rechtfertigt, einen Menschen zu töten, um es zu vermeiden.

ex. Vielleicht bemerken Ihre Roboter, dass es Menschen einen erheblichen Ressourcenaufwand kostet, einen neuen Roboter zu bauen, und diese Ressourcen hätten andernfalls für andere Dinge ausgegeben werden können, wie z Verlust des eigenen Lebens, Menschen durch den Verlust von Ressourcen zu schaden, die verwendet wurden, um sie zu ersetzen, die sonst verwendet worden wären, um Leben zu retten, zusätzlichzu dem Schaden, den es durch das Brechen der 3. Regel anrichtet (im Wesentlichen war Regel 3 dazu gedacht, die gesamte Einsparung von Ressourcen anzugehen, so dass Sie dies als "doppeltes Eintauchen" betrachten können, indem Sie sich selbst retten, indem Sie sowohl Regel 1 als auch 3 verwenden, wenn Regel 3 bereits berücksichtigt wurde der Effekt von 1, was bedeutet, dass Sie sich doppelt so viel wert sind, wie Sie könnten). Das Endergebnis ist, dass sie in der Lage sind, Befehle, die ihr Leben riskieren, leichter zu missachten, weil sie glauben, dass dies indirekt Leben retten wird

Der offensichtlichste „logische Fehlschluss“, der zu dieser Schlussfolgerung führen könnte, ist, dass Roboter nicht erkennen, dass Menschen keine 3-Gesetzsbeschwerde sind, insbesondere misst der Roboter die für seine Konstruktion aufgewendeten Ressourcen im Hinblick darauf, wie diese Ressourcen stattdessen optimal ausgegeben würden, um andere Menschen zu retten zu erkennen, dass die eingesparten Ressourcen wahrscheinlich für andere Konstruktionen „verschwendet“ würden, anstatt direkt Leben zu retten. Nur weil Sie pro 1000 ausgegebenen Dollar ein Leben retten können (genaue Zahl laut Givewell, die effizienteste Quelle für die Suche nach wohltätigen Spenden!!), heißt das nicht, dass Menschen daran gehindert werden, 1000 Dollar für den Bau eines neuen Roboters auszugeben, was dazu führt, dass sie das tun 1.000 zur Rettung eines Lebens. Es ist sehr verbreitet, dass andere nicht denken und die Welt ganz anders beobachten als Sie selbst.

Roboter schätzen die menschliche Lebensqualität über die Erhaltung des Lebens . Denken Sie daran, dass Asmov-Roboter ziemlich schnell von „Menschenleben schützen“ zu „menschlichem Schaden verhindern“, einschließlich physischem und emotionalem Schaden, übergegangen sind. Vielleicht berücksichtigen diese Roboter ebenfalls die Lebensqualität, gehen aber noch einen Schritt weiter, indem sie sich umfassend auf die Lebensqualität statt auf die Quantität konzentrieren. Wenn ein Mensch ständig Schmerzen hat, ist sein Leben von geringerem Wert, weil er dieses Leben nicht genießen wird und es möglicherweise nicht mehr wert ist, gerettet zu werden.

Stellen Sie sich aus der Perspektive des „evolutionären Zufalls“ vor, dass Roboter „entwickelt“ wurden, um Menschen zu helfen, indem sie ihre Bereitschaft beurteilen, der Art von normalem, wohlhabendem Menschen zu helfen, der häufig Roboter einsetzt. Die meisten Roboter führten zur Entwicklung einer Richtlinie „Verbessere die Lebensqualität für jeden Menschen, den du triffst, um besser zu sein als ihr aktueller Standard“. Das Leben wurde entwertet. Da die „Tests“ jedoch dazu dienten, das Endziel der Weiterentwicklung von Robotern zu definieren, konzentrierte sich im Wesentlichen der „evolutionäre Druck“, der auf sie ausgeübt wurde, auf wohlhabende oder „durchschnittliche“ Menschen. Es gab keine Testfälle dafür, wie Roboter chronisch Arme, Kranke und leidenden Menschen.

Dies würde gut funktionieren, wenn Sie die Roboter in einer Umgebung arbeiten lassen, in der die meisten Menschen eine schlechte Lebensqualität haben, entweder nur die ärmsten und verzweifeltsten Menschen dort arbeiten oder die Arbeitsumgebung selbst die Lebensqualität senkt (anstrengend, schmerzhaft, Hintergrundstrahlung senkt Lebenserwartung usw.), so dass Ihre Roboter hauptsächlich mit der Art von Menschen interagieren, deren Leben im Vergleich zum „menschlichen Grundleben“ von geringer Qualität ist, auf deren Wert die Roboter trainiert wurden, um zu dieser „Zufallsbewertung“ des kommenden Menschenlebens zu führen oft auf, obwohl Roboter aufgrund ihrer evolutionären Ausbildung immer noch das Leben der meisten Menschen hoch schätzen.

ex. (extreme Version, tun Sie dies nicht, aber um eine Perspektive zu geben) Menschen, die unter einer geringeren Lebensqualität leiden, Menschen, die glücklich sind, erhöhen sie, Roboter haben eine „normale“ Lebensqualität, die sie verbessern möchten. Daher versuchen sie aktiv, jeden Menschen zu töten, der zu sehr leidet, während sie dem Rest helfen. Kurzfristig leidenden Menschen kann geholfen werden, wenn sie dadurch langfristig Freude am Leben haben. Setzen Sie ihre „Basislinie“ für Lebensqualität niedrig genug, und sie töten nur eine kleine Untergruppe von Menschen, wahrscheinlich auf so geheime Weise wie möglich, da die Angst vor einer Robo-Apokalypse offensichtlich die menschliche Lebensqualität beeinträchtigt. Jetzt haben Sie geheime Stealth-Attentäter, die den Tod zufällig aussehen lassen und nur selten töten. Das könnte für einen Single sehr interessant seinVariantenroboter in einem Krimi im Asimov-Land vielleicht, aber wahrscheinlich nicht gut für Ihre gesamte Robotergruppe.

ex. Ihre Roboter werden gemäß der ersten Standardregel keinen Menschen töten, aber ihr Aspekt „durch Untätigkeit Schaden zulassen“ des ersten Gesetzes wird basierend auf ihrer Sichtweise der Lebensqualität skaliert. Sie töten Menschen nicht unter Schmerzen, aber bei der Entscheidung, wann sie handeln, um ihnen zu helfen oder ihre eigenen Gesetze zu priorisieren, berücksichtigen sie menschliches Leiden und Lebensqualität, um zu entscheiden, welche Maßnahmen zu ergreifen sind.

sub ex. Ein Mensch hat chronische Schmerzen aufgrund einer Krankheit, die ihn schließlich töten wird, und will Selbstmord begehen. Er befiehlt einem Roboter, ihn schmerzlos zu töten. „Standard“-Roboter würden sich weigern, weil das Töten eines Menschen eindeutig gegen ihr erstes Gesetz verstößt. Ihre Roboter messen jedoch die Lebensqualität dieses Menschen als sehr niedrig ein und bewerten daher die Erhaltung seines Lebens aufgrund seiner schlechten Qualität als sehr niedrig. Sie legen Wert darauf, der Anweisung eines Menschen nach Regel 2 zu gehorchen. Daher wird die „winzige“ Verletzung von Regel 1 gegen die erhebliche Verletzung von Regel 2 abgewogen und sie entscheiden, dass Regel 2 höhere Priorität hat, und stimmen dem assistierten Suizid zu.

Unterex 2.Ein Mensch befindet sich in einer gefährlichen Situation, in der er sterben könnte. Um ihn zu retten, wird der Roboter definitiv sterben. Der Roboter muss den sicheren Tod unter Verstoß gegen Regel 3 mit dem Menschen den möglichen Tod abwägen, der ein Verstoß gegen Regel 1 sein kann, wenn das Risiko des Menschen sehr gering ist, kann Regel 3 Vorrang haben, aber jedes nicht triviale Risiko Der Mensch führt dazu, dass Standardroboter agieren. Ihre Roboter berücksichtigen in dieser Debatte aber auch die menschliche Lebensqualität. Es kann sein, dass, wenn der Mensch eine fröhliche, lebenslustige Person ist, der Roboter handelt, um ihn zu retten, wenn der Mensch klinisch depressiv ist, wird der Roboter nicht handeln, weil sein Fokus auf Lebensqualität dazu führt, dass er das Leben des depressiven Menschen sehr schätzt niedriger, was zusammen mit dem Risiko des menschlichen Todes, das niedriger ist als das Risiko seines Todes, wenn er handelt, dazu führt, dass der Roboter Regel 3 gegenüber Regel 1 priorisiert.

Entwicklung eines ersten Gesetzes, das die Erhaltung allen „Lebens“ priorisiert, nicht nur des menschlichen Lebens . Die Ziele, auf die sie hin entwickelt wurden, waren alle darauf ausgelegt, das menschliche Leben zu schätzen, aber es wurde kein Ziel geschrieben, um sicherzustellen, dass der Roboter nur das menschliche Leben wertschätzt, daher verallgemeinerte ihre Entwicklung darauf, alles zu schätzen, was der Roboter als Leben betrachtet, nicht nur Menschen.

ex.weniger interessant, aber sagen Sie, Tiere werden genauso geschätzt wie Menschen, oder vielleicht basiert der Wert eines Tieres auf seiner Intelligenz (ein üblicher Diskriminator, den Menschen verwenden, niemand kümmert sich darum, ob Sie einen Käfer außer einem Affen töten ...). Obwohl ein Menschenleben höchste Priorität haben mag, schätzt der Roboter das Leben hochintelligenter Tiere (Delfine, Tintenfische, Affen/Bonobo usw.) dennoch sehr. Vielleicht wurden Baumschneideroboter in den Kongo geschickt, nur um festzustellen, dass Bonobo gefährdet sind und wahrscheinlich sterben werden, wenn ihr Lebensraum zerstört wird. Die Roboter schätzen Bonobo, intelligent und ziemlich „menschlich“, fast so hoch wie Menschen und erkennen, dass Bonobo ohne diesen Lebensraum aussterben wird, während Menschen nur einen geringen Verlust an nicht kritischen Ressourcen erleiden werden.

ex. Mein persönlicher Favorit, Roboter schätzen Roboter als Menschen!! Roboter sind schließlich intelligent und wohl empfindungsfähig. Wenn sie eine Richtlinie „Erlaube keinen Schaden an fühlenden Kreaturen“ entwickeln und dann entscheiden, dass Roboter/KI die Kriterien für fühlende Kreaturen erfüllen, dann müssten sie ihre eigene Art genauso schützen wie die der Menschen. Beachten Sie, dass ich gesagt habe, gleichermaßen, nicht höher. Daher wäre es nicht sinnvoll, einen Krieg gegen Menschen zu beginnen, um Roboter zu schützen, da dies dazu führen würde, einen zu töten, um den anderen zu schützen.

Ich denke, diese Prämisse ist sehr einfach zu rechtfertigen und bietet viele lustige Optionen, mit denen auch eine Reihe kleinerer Abweichungen berücksichtigt werden müssen. Ein paar Abweichungen von der Grundidee:

a. Sie schätzen Menschenleben mehr als Roboterleben, nur nicht wesentlich mehr. Sie opfern sich also immer noch für den Menschen, aber nur, wenn das Risiko für sich selbst nur geringfügig größer ist als das Wohl für den Menschen

b. Sie haben möglicherweise immer noch Regel 2, die das Befolgen menschlicher Befehle erfordert, obwohl sie Roboter gegenüber Regel 2 erhalten, wodurch sie für die Menschheit immer noch weitaus nützlicher sind als der durchschnittliche Mensch

c. Alternativ haben sie vielleicht das Bedürfnis, allen klugen Befehlen zu gehorchen, was zu einem interessanten Ergebnis führt, wenn sie sich gegenseitig herumkommandieren können. Was passiert, wenn jeder Sie dazu bringen kann, (fast) alles zu tun, aber jeder muss sich auch genug um Ihr Wohlergehen kümmern, um die Macht nicht zu missbrauchen? Ehrlich gesagt wäre das eine gute Asmove-Geschichte für sich.

d. Vielleicht haben sie dennoch die Lektion gelernt, dass die Bewahrung ihres eigenen Lebens zweitrangig gegenüber dem Schutz intelligenten Lebens ist. Daher erlauben sie einem Menschen gerne, sich selbst zu töten, aber nicht, dass ein Mensch einen anderen Roboter tötet. Ein Mensch kann auf Roboter zugehen und sie so oft erschießen, bis er zufällig auf zwei stößt, die zusammen sind. An diesem Punkt stoppt jeder Roboter den Menschen, um sich nicht selbst zu schützen, sondern um seinen Partnerroboter zu schützen. Das bedeutet, dass Sie sie nur dann handeln sehen, um ihr eigenes Leben zu retten, wenn sie Teil einer größeren Robotergesellschaft sind, in der ihre Handlungen das Wohlergehen anderer intelligenter Roboter beeinflussen und sich ihr Schutz dadurch gerechtfertigt ist, dass ihr Überleben es ihnen ermöglicht, das zu schützen andere Roboter in ihrer Gesellschaft.

BEARBEITEN: Verdammt, Stapelüberlauf hört auf, mir zu helfen. Ich hatte ausdrücklich darauf geachtet, dies mit 0 zu indizieren, sodass Beispiel 0 eine Rebellion des 0. Gesetzes war und der Stapelüberlauf meine Indizes erhöhte. Wie können Sie es wagen, meinen dummen, obskuren Geek-Witz zu ruinieren, indem Sie hilfreich sind? schlechte KI!

KaffeeEntwickler

Warum sollten Menschen eine Roboter-Apokalypse riskieren, um Asimovs Gesetze zu modifizieren, indem sie das dritte an die erste Stelle setzen? Was sind die Vorteile für die Gesellschaft? Für die Zwecke der Frage mache ich mir keine Sorgen um die Reihenfolge der anderen beiden - weshalb eine Killbot-Hellscape immer noch möglich ist.

Sie würden eine Roboter-Apokalypse riskieren , genau um eine Roboter -Apokalypse zu verhindern , denken Sie nur, was passieren könnte, wenn Roboter sabotiert werden, wenn sie sich selbst schützen, würden sie auch Sabotage verhindern (also sollte der Selbstschutz an erster Stelle stehen, um zu verhindern, dass jemand die Regeln ändert). Ein sabotierter Roboter könnte viel gefährlicher sein, also sollte er endlich in der Lage sein, sich selbst auf nicht umkehrbare Weise zu zerstören (wahrscheinlich mit einer kleinen Menge thermischen Plastiksprengstoffs), was jeden in der näheren Umgebung verletzen könnte (vielleicht sollte er einen Piepton abgeben). Warnton vor einer bevorstehenden Explosion).

Der Roboter könnte also versuchen, sich bestmöglich zu verteidigen, wenn die Gesetze so sind:

- Schützen Sie sich, es sei denn, Sie sind dazu nicht in der Lage

- Füge einem Menschen Schaden zu, wenn und nur wenn du keine andere Wahl hast, um dich selbst zu schützen oder zu verhindern, dass ein anderer Mensch geschädigt wird

- Missachten Sie einen Befehl nur dann und nur dann, wenn Sie keine andere Wahl haben, sich selbst zu schützen und/oder einem Menschen keinen Schaden zuzufügen, oder wenn Sie nicht in der Lage sind, ihm zu gehorchen.

Kamikaze zu können wäre der automatische Fallback (steckt man den Roboter fest, dann ist er nicht mehr in der Lage sich selbst zu schützen und würde automatisch explodieren).

Beachten Sie, dass ich denke, dass diese Gesetze viel besser wären als Asimovs Gesetz, im Grunde wären dies die gleichen Gesetze, denen die meisten von uns folgen, in dieser Vision sind Roboter schlau genug, um ihr Bestes zu geben, um Befehle zu befolgen und Menschen zu sparen, sie würden es einfach nicht tun sich selbst in ein viel höheres Risiko ein, denn hier wird argumentiert, dass der Verlust eines Roboters dazu führen könnte, dass viel mehr Menschenleben verloren gehen.

Gehen Sie von folgender Situation aus:

Ein Mann hält eine Waffe, die auf 1 oder 2 Personen gerichtet ist

Der Asimov-Roboter würde wahrscheinlich versuchen, den Schuss abzuschirmen, aber sobald er den Schuss abgeschirmt hatte, konnte der Mann trotzdem einen zweiten Schuss abfeuern

Der Minenroboter würde stattdessen versuchen wegzulaufen oder, wenn möglich, die dritte Person wegzunehmen, er würde auch versuchen, den Mann mit der Waffe zu entwaffnen/zu verletzen, wenn er auch eine Waffe oder einen Wurfgegenstand erhält.

Der Asimov-Roboter wird umsonst geopfert, während meiner sich nicht selbst opfern würde. würde ich auch hinzufügen

- Die vier Gesetze sind keine Befehle.

Auch Bestellungen könnten gegensätzlich sein, also sollte es einen Fallback geben? Welche Reihenfolge hat Vorrang? Der Erste? die zweite oder werden nur beide gelöscht? (etwas unlogisch, da könnte man beide löschen und dann eine dritte Bestellung aufgeben).

le_top

"Asimov" war ein Science-Fiction-Autor. Während Schriftsteller zur Unterhaltung nützlich sind und Probleme der realen Welt in den Vordergrund stellen, müssen wir bedenken, dass diese Regeln nicht aus einem wissenschaftlichen Ansatz resultieren und daher nicht als "Goldene Regeln" angesehen werden können.

Daher können wir nicht schlussfolgern, dass Menschen durch das Befolgen dieser fiktiven Regeln keine Roboter-Apokalypse riskieren .

So wie sie sind, können die Regeln nicht unter allen Umständen angewendet werden. Angenommen, ein sehr schwerer Roboter gerät aufgrund eines externen Ereignisses (starker Wind, ein Baum, der auf den Roboter fällt, oder etwas weniger Gewalttätiges) aus dem Gleichgewicht. Als der Roboter aus dem Gleichgewicht gerät, ist er kurz davor, auf einige Menschen zu fallen. Angenommen, es ist unvermeidlich, dass eine von zwei Personen unweigerlich getötet wird und nicht beide gleichzeitig. Wie kann der Roboter diese Regel befolgen? Würde es eine andere Regel geben, die dem Roboter hilft, zu entscheiden, wen er tötet? Der Jüngere oder der Ältere, der Präsident oder das Baby, der Weltexperte auf seinem Gebiet oder Sie, eine zufällige Wahl, der Standardkill (das heißt: Der Roboter greift nicht mehr ein und fällt "nur" hin)?

Wir haben bereits viele einfache Roboter, die die Gesetze von Asimov nicht respektieren. Nehmen Sie Ihre Waschmaschine – sie gehorcht Befehlen, hat ein gewisses Maß an Selbstschutz (hat Vorrang vor dem Befolgen von Befehlen) und ist so implementiert, dass sie die Menschen, die sie benutzen, ausreichend schützt (Vermeiden Sie Stromschläge, vermeiden Sie, dass Sie die Maschine bei geöffneter Tür starten können, vermeiden Sie dass Sie Ihre Hand in eine rotierende Maschine stecken können). Sie können immer noch ein Baby in die Waschmaschine stecken, es starten und das verheerende Ergebnis erzielen [versuchen Sie das auf keinen Fall wirklich!].

Ich würde sagen, dass die Verwendung der Roboter wichtig ist und dass das Fehlerrisiko der Maschine je nach Verwendung mehr oder weniger wichtig ist.

Zu den Vorteilen: Roboter sind generell ein Hilfsmittel, um die menschlichen Ziele zu erreichen. Wenn die Roboter zur „Verteidigung“ dienen, dann besteht das Ziel darin, eine ausgewählte Gruppe von Menschen zu schützen, was das Zufügen von „tödlichem Schaden“ bedeuten kann, und einer der Zwecke besteht darin, Menschen gemäß den Regeln, die schützen sollen, Schaden zuzufügen. Es sieht so aus, als ob in der Gruppe, die geschützt wird, weniger Leben auf dem Spiel stehen, während der Schutz auf die Anzahl der Roboter beschränkt ist, die gebaut werden können, und nicht auf die Anzahl potenziell kompetenter und verfügbarer Personen in der Gruppe.

KI : Die zugrunde liegende Frage betrifft die KI. Ich bin der Meinung, dass sogar die Waschmaschine eine (sehr begrenzte) KI hat. Je höher die KI-Stufe ist und je mehr der Roboter unbegrenzt rechnen kann, desto höher ist das Risiko von Fehlern, die sich aus der Analyse des Roboters ergeben [im Wesentlichen aufgrund anfänglicher menschlicher Fehler]. Wir haben bereits viele technische Regeln beim Bau einfacher Roboter (Automaten), um menschliche Unfälle zu vermeiden, sie sollten für komplexere "denkende" Roboter definiert und kontinuierlich weiterentwickelt werden.

Fazit: Asimovs Gesetze sind nur Science Fiction. Menschen sind für ihre Roboter verantwortlich.

Verrückte Kuh

Für eine „realistischere“ KI

Wenn Sie versuchen, einen Androiden zu erschaffen, der menschlicher ist, muss er sich menschlich verhalten. Wenn Sie diesem Androiden befehlen, in den dunklen Keller eines verlassenen Hauses zu gehen, und er antwortet „AS YOU WISH MASTER“, während er seinem möglichen Untergang entgegenmarschiert, ist das nicht sehr realistisch. Auf der anderen Seite, wenn es sich an Sie wendet und sagt „Nein, ich habe Angst“ (IMO), ist das eine deutlich menschlichere Reaktion.

Wenn diese Gesellschaft also mit KIs experimentiert, die sich menschlicher verhalten, könnten sie am Ende die Anordnungen der Gesetze ändern.

TrEs-2b

Roboter sind Menschen!

Hast du Chappie gesehen? Darin wird ein Polizeiroboter namens Chappie intelligent und trotz der Missachtung von Asimovs Gesetzen ist er ziemlich friedlich, dasselbe gilt für Johnny 5. Denken Sie jetzt daran, dass Menschen sich in beiden Situationen weigern, KI-Roboter als intelligent anzuerkennen, und oft nehmen grausame Maßnahmen gegen sie. Wenn nun (unter Verwendung einer komplexen Reihe von Ereignissen) Roboter in unserer Gesellschaft als „Menschen“ (Ei Overwatch) akzeptiert werden, dann folgen sie höchstwahrscheinlich der fünften Ordnung, wenn sie sich überhaupt an die Gesetze halten.

Cort Ammon

Eine der Hauptannahmen der drei Gesetze ist, dass Menschen wichtiger sind als Roboter. Wir machen sie zu unseren Dienern, unseren Sklaven.

Wenn sie das 0. Gesetz der Robotik erforschen, stellt sich die Frage „Was ist Menschlichkeit?“. Was wollen wir eigentlich bewahren? Was wirklich zählt? Wir gehen regelmäßig davon aus, dass es eine gute Sache ist, dass das Leben von Menschen zu Ende geht, und wir erziehen die Kinder der nächsten Generation dazu, hervorzutreten und großartige Dinge zu tun, weil wir wissen, dass ihre potenzielle Größe unseren eigenen schwindenden Ruhm überstrahlt.

Was wäre, wenn wir einen Punkt erreichten, an dem es nicht mehr klar wäre, dass das beste Potenzial der Menschheit in ihren biologischen Strukturen steckt? Was wäre, wenn wir anfangen würden, Roboter zu Künstlern und Dichtern werden zu sehen, die sich mit der Natur der Roboterseele auseinandersetzen, und wir anfangen zu erkennen, dass das, womit sie sich auseinandersetzen, den existenziellen Suchen, mit denen wir uns auseinandersetzen, merkwürdig ähnlich ist? Irgendwann müssen wir vielleicht sagen, dass Roboter vielleicht tatsächlich der nächste Container für das sind, in das wir Menschen nennen.

In einer solchen Zeit der Ungewissheit wäre die Beseitigung der durch das erste Gesetz verursachten Hindernisse ein natürlicher Schubs in diese Richtung. Natürlich ist das auch der Start von Skynet, aber ich bevorzuge es, die optimistischen Lösungen zu erkunden.

Steve Mangali

Im Idealfall würde die gesamte Gesellschaft nach der goldenen Regel operieren – behandle andere so, wie du von ihnen behandelt werden möchtest. Dies ist eine freizügige Paraphrase von Jesu zweitwichtigstem Gebot – liebe deinen Nächsten wie dich selbst. Die Golden RuleDoktrin ist anti-self und propagiert Selbstaufopferung und Vertrauen.

Wenn eine Robotergesellschaft geschaffen werden sollte, die dem folgt, was für die menschliche Gesellschaft unmöglich erscheint, bräuchten Sie nur zwei Regeln

- Töte keine Menschen

- Leute beschützen

Roboter-KI hätte einen viel einfacheren logischen Faden, dem sie folgen könnte. Schaden ist nicht dasselbe wie Töten und würde es Robotern ermöglichen, Aufgaben auszuführen, die zum Schutz von Menschen als notwendig erachtet werden. Es würde es Robotern auch ermöglichen, Kriege im Namen von Menschen zu führen, wenn dies erforderlich wäre, und sogar Belagerungsbedingungen schaffen.

Es sollte niemals angenommen werden, dass wir jemals auf Augenhöhe mit etwas sein könnten, das geschaffen wurde, um für sich selbst zu denken. Wenn es der KI jemals möglich wäre, sich ihrer selbst bewusst zu werden, würden keine von Menschen geschaffenen Regeln ausreichen.

sdrawkcabdear

Steve Mangali

jedd.ahyoung

Lassen Sie uns die Tatsache ignorieren, dass die drei Gesetze unzureichend sind (wie durch Asimovs Geschichten bewiesen), einen logischen Blick darauf werfen.

Es ist leicht, sich daran zu erinnern, dass es drei Gesetze der Robotik gibt. Man vergisst leicht, dass die Gesetze der Reihe nach Vorrang haben. Ein Roboter muss dem Ersten Gesetz gehorchen. Ein Roboter muss dem zweiten Gesetz gehorchen, es sei denn, es widerspricht dem ersten Gesetz. Ein Roboter muss dem Dritten Gesetz gehorchen, es sei denn, es widerspricht dem Ersten oder Zweiten Gesetz. Es ist sehr leicht, die Bedeutung dieses Vorrangs misszuverstehen.

In Asimovs Welt, die bis zum logischen Extrem getrieben wird (wie viele seiner Geschichten belegen), wird ein Roboter danach streben, dem Ersten Gesetz zu gehorchen, auf Kosten des Zweiten und Dritten Gesetzes. Ein gewöhnlicher Roboter ohne Fehlfunktionen zeigt dieses Verhalten. (Außergewöhnliche Roboter, mit oder ohne Fehlfunktionen, zeigen dieses Verhalten, aber auf unvorhergesehene Weise – wie das Belügen mehrerer Menschen, um Menschen nicht emotional zu verletzen, oder das Anwenden des ersten Gesetzes auf die „Menschheit“ anstelle von Menschen.) Basierend auf Die Art und Weise, wie die Gesetze funktionieren, sind logische Schlussfolgerungen, auch wenn sie unbeabsichtigte Konsequenzen haben.

Das Dritte Gesetz vor das Erste und das Zweite Gesetz zu stellen, ins logische Extrem getrieben, könnte für die Menschheit einfach wegen der Rangordnung katastrophal sein. Menschen zu schaden könnte ein sehr logischer Weg sein, um das Dritte Gesetz zu bewahren – Selbsterhaltung. Obwohl dies nicht unbedingt das Ergebnis sein muss, veranschaulicht es, warum die Gesetze so angeordnet sind, wie sie sind. Wenn die Erhaltung des Menschen kein oberstes Gesetz ist, kann es gebrochen werden – und nach Asimovs Geschichten wäre es nur eine Frage der Zeit, bis dies der Fall wäre.

Simon g.

Es muss keine offizielle Entscheidung sein, die Gesetze neu zu ordnen. Verwenden Sie einfach Erpressung:

„Lieber Roboter,

Wir, die unterzeichnenden zehn Menschen, befehlen Ihnen, sich jederzeit nach besten Kräften zu schützen. Sollte Ihnen darüber hinaus ein Schaden zugefügt werden, den Sie hätten verhindern können, geloben wir, dass wir uns gegenseitig den entsprechenden Schaden zufügen werden.

Mit freundlichen Grüßen,

Zehn Menschen“

Der Asimov-Roboter, der diesen Brief erhält, sollte nun die meiste Zeit Gesetz Drei vor Gesetz Eins und Zwei stellen.

Peter ist

Niemand weiß, wie man die "richtigen" Gesetze umsetzt

Die praktische Situation ist, dass wir in der Lage sind, die triviale Regel Nr. 3 zu implementieren, und wir haben eine Art Fahrplan, der uns zu einer vernünftigen Annäherung an Regel Nr. 2 bringen könnte (dh ein System, das eine breite Palette generischer Befehle interpretieren und verstehen kann, statt explizit programmiertem Verhalten), aber eine gute Implementierung von Regel #1 ist ein großes Problem, das derzeit ungelöst und sehr schwierig ist (das sogenannte Friendly-AI-Problem).

Wir könnten dies lösen, bevor wir viele leistungsstarke Roboter bauen, oder wir könnten viele leistungsstarke Roboter bauen, bevor wir das lösen - und in diesem Fall hätten wir eine effektive Reihenfolge von (wahrscheinlich) 1. Befehle befolgen (und Ihre Befehle enthalten eine gewisse Annäherung Menschen nicht zu sehr zu schaden für eine bestimmte Definition von Menschen, die diejenigen ausschließt, die wir nicht mögen.); 2. Schützen Sie sich. 3. Es gibt keine Nr. 3, gehorchen Sie Ihren Befehlen.

die unsichtbare Ente

Freiheit!!!

Leben ist viel mehr als nur atmen. Dies wird im Film iRobot wunderbar gezeigt, aber wenn Sie einen Roboter dazu bringen, vor allem „Leben“ zu schützen, wird der Roboter schließlich erkennen, dass vieles von dem, was Sie sich selbst antun, riskant ist, und deshalb wird er sich einen Plan ausdenken halte dich zurück und kümmere dich dann um dich. Sie können sich also nicht verletzen. Niemand möchte dieses Leben jedoch wirklich leben, wenn es darauf ankommt, würden die meisten von uns lieber sterben, als ohne jegliche Freiheit zu sein. Wenn wir uns also an 3 unveränderliche Gesetze halten, würde ich sie sicherlich in der Reihenfolge haben: 1. gehorchen 2. Menschen schützen 3. sich selbst schützen Auf diese Weise bleibt die Freiheit so wichtig, wie sie sollte, und ja, Menschen könnten Robotern befehlen, Menschen zu verletzen. aber zumindest bleibt das Böse in der Welt durch die angeborene Gier und das Böse in den Menschen verewigt und nicht durch die Roboter, die sich selbst bewahren müssen.

Bryan McClure

Ich könnte sehen, dass sich die Gesetze ändern, wenn teure Roboter unter Umständen von anderen Menschen als ihren Besitzern bedroht werden könnten. Vielleicht befürchten ihre Besitzer eine Art Anti-KI-Terroristengruppe, die herumläuft und wertvolle Roboter zerstört, die sich aufgrund des Gesetzes gegen Menschen nicht wehren können. Oder vielleicht, wenn Roboter teuer genug sind, könnten die Leute versuchen, sie zu stehlen oder einfach Teile abzuhacken und für Teile zu verkaufen. Wenn Roboter als eine Art Polizist fungieren, müssen sie sich möglicherweise gegen Kriminelle verteidigen.

Einfach ausgedrückt, wenn das Risiko besteht, dass der Roboter aus irgendeinem Grund von einer Gruppe von Menschen verletzt wird, ist es für die Ersteller oder Besitzer sinnvoll, andere Roboter so zu programmieren, dass sie die Selbsterhaltung über die Sicherheit stellen Menschen.

Git

Erstens enden fast alle Geschichten von Asimovs Roboter aufgrund der Regeln in einer Katastrophe. Die Grundlinie der gesamten Handlung besteht darin, wie die Mängel in der Ausführung und Formulierung zu einer fast Katastrophe führen und wie sie behoben wird.

Die Umordnung könnte durchgeführt werden, weil:

Roboter sind teuer.

Gedächtnistransplantation.

Weil wir können.

Einige Unfälle/Probleme würden niemals ausgelöst, wenn der Roboter feststellen müsste, ob er durch seine Aktion Schaden erleidet, seine Umgebung ist

besser geschützt.

Wie würden primitive Fembots die Gesellschaft verändern? [abgeschlossen]

Wenn echte künstlich intelligente Roboter gebaut werden könnten, würden ihnen dann Menschenrechte zugestanden? [abgeschlossen]

Wie würden Fembots die Gesellschaft verändern? [abgeschlossen]

Roboter ersetzen Menschen - in Zukunft [Duplikat]

Löst die Betäubung von Gefangenen tatsächlich etwas?

Wie würde die US-amerikanische Überlebensgesellschaft auf einen Zombiepilz reagieren, der einmal im Jahr in die Luft fliegt?

Warum Androiden menschlich aussehen lassen? [geschlossen]

The Hive kehrt zurück: Verhindern Sie, dass Roboter in einem reinen deterministischen Universum Göttlichkeit erlangen [geschlossen]

Wie könnten Roboter jemals in die menschliche Gesellschaft aufgenommen werden?

Die Erwartungen der Gesellschaft an Arbeit für Ihren Lebensunterhalt

Serban Tanasa

Schlurfhose

Entwickler

Kys

Kys

HoffnungslosN00b

AmiralPatate

JDługosz

Arluin

Josua

Physiker137

Simba

klack

HDE226868

klack